Mercury Coder 是由 Inception Labs 开发的一款基于扩散技术的大型语言模型(dLLM),专为高效编程和文本生成设计。以下是关于 Mercury Coder 的详细介绍:

1. 技术特点

Mercury Coder 采用了扩散模型生成方法,与传统的自回归模型(如 ChatGPT)不同,它能够同时生成完整的响应,而不是逐字生成。这种方法通过逐步“去噪”从遮蔽状态优化成连贯的文本,显著提高了生成速度和效率。

-

扩散模型:与图像生成模型(如 Stable Diffusion)类似,Mercury Coder 使用遮蔽 token 作为噪声的等效物,通过逐步去噪生成文本。这种方法允许模型并行处理所有 token,从而大幅提升生成速度。

-

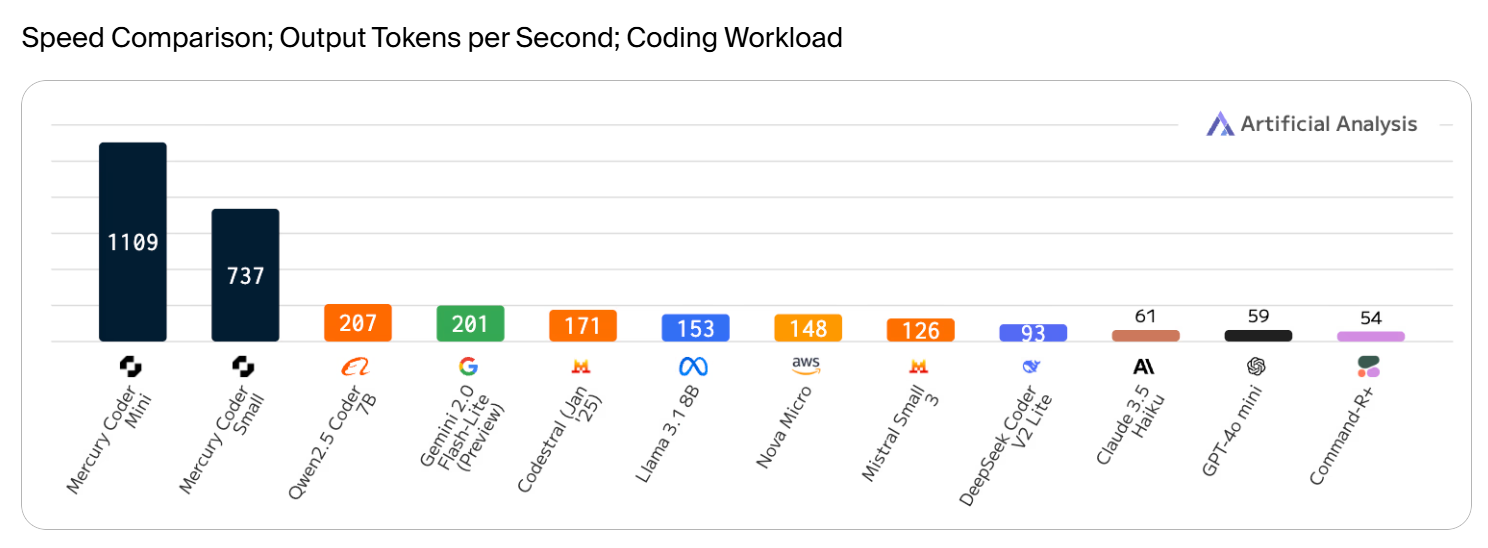

高效推理:在英伟达 H100 GPU 上,Mercury Coder 的生成速度超过每秒 1,000 个 token,比传统的自回归模型(如 GPT-4o Mini)快约 19 倍。

2. 性能表现

Mercury Coder 在编程任务中表现出色,尤其在代码生成和补全方面:

-

HumanEval 基准测试:Mercury Coder Mini 在 HumanEval 上得分为 88.0%,在 MBPP 上得分为 77.1%,与 GPT-4o Mini 相当,但速度更快。

-

多语言支持:Mercury Coder 不仅支持主流编程语言,还能处理多种编程任务,包括代码补全、代码解释和代码修改。

3. 应用场景

Mercury Coder 的高效性和并行处理能力使其适用于多种场景:

-

代码补全工具:即时响应能力可显著提升开发者生产力。

-

会话 AI 应用:在需要快速响应的对话场景中表现出色。

-

资源受限环境:如移动设备和边缘计算场景,Mercury Coder 的高效性使其成为理想选择。

4. 商业化和开放试用

Inception Labs 已上线 Mercury Coder,并提供公开试用。企业用户可以通过 API 或内部部署的方式使用该模型,满足定制化需求。

5. 未来展望

Mercury Coder 的推出标志着扩散模型在文本生成领域的突破。尽管目前其性能与 GPT-4o 等顶级模型相比仍有差距,但其速度和效率优势为 AI 文本生成开辟了新的方向。

总结来说

Mercury Coder 是一款基于扩散技术的高效编程语言模型,具有显著的生成速度和性能优势,适用于多种编程和文本生成场景。扩散语言模型将为LLM解锁一系列新能力:

1. 强化智能体——dLLMs的快速响应和高效特性,使其成为需要复杂规划和长序列生成的智能体应用的理想选择

2. 进阶推理能力——dLLMs可利用错误校正机制修复模型幻觉并优化答案,且推理过程仅需秒级时间,显著优于当前需要数分钟推理的自回归模型

3. 可控内容生成——dLLMs支持输出编辑和乱序token生成,用户可实现文本插值、确保输出符合安全目标,或生成严格遵循用户指定格式的内容

4. 边缘计算应用——凭借其高效特性,dLLMs在手机、笔记本电脑等资源受限的边缘计算场景中表现卓越

免责声明:本网站仅提供网址导航服务,对链接内容不负任何责任或担保。